Cette année, les entreprises de tous les secteurs déploient des services d’IA. Microsoft, Oracle, Perplexity, Snap et des centaines d’autres entreprises de premier plan considèrent que l’utilisation de la plateforme d’inférence de l’IA de NVIDIA, une pile complète comprenant du matériel de pointe, des systèmes et des logiciels hors pairs, est la clé pour offrir une inférence haut débit et à faible latence et de meilleures expériences utilisateur, tout en réduisant les coûts.

Les avancées de NVIDIA en matière d’optimisation des logiciels d’inférence et la plateforme NVIDIA Hopper aident les industries à prendre en charge les nouveaux modèles d’IA générative, et à offrir une excellente expérience utilisateur tout en optimisant le coût total de possession. La plateforme Hopper permet également de multiplier l’efficacité énergétique par jusqu’à 15 pour les charges de travail d’inférence par rapport aux générations précédentes.

L’inférence de l’IA est notoirement difficile, car elle nécessite de nombreuses étapes pour trouver le bon équilibre entre débit et expérience utilisateur.

Mais l’objectif sous-jacent consiste simplement générer plus de jetons à moindre coût. Les jetons représentent des mots dans un système de grand modèle de langage (LLM). Et comme les services d’inférence de l’IA facturent généralement chaque million de jetons générés, cet objectif offre le retour sur investissement en IA le plus visible.

L’optimisation logicielle complète est la clé pour améliorer les performances d’inférence de l’IA et atteindre cet objectif.

Un rendement utilisateur rentable

Les entreprises sont souvent confrontées à la recherche d’un équilibre entre les performances et les coûts des charges de travail d’inférence. Si certains clients ou cas d’utilisation peuvent fonctionner avec un modèle prêt à l’emploi ou hébergé, d’autres peuvent nécessiter une personnalisation. Les technologies NVIDIA simplifient le déploiement des modèles tout en optimisant les coûts et les performances pour les charges de travail d’inférence de l’IA. De plus, les clients ont la possibilité de personnaliser les modèles qu’ils choisissent de déployer.

Les microservices NVIDIA, le serveur d’inférence NVIDIA, le serveur d’inférence NVIDIA Triton et la bibliothèque NVIDIA TensorRT font partie des solutions d’inférence de NVIDIA est de l’inférence de NVIDIA.

- Les microservices d’inférence NVIDIA NIM sont préconfigurés et leurs performances optimisées afin de permettre un déploiement rapide de modèles d’IA de base sur n’importe quelle infrastructure (Cloud, Data Centers, Edge ou stations de travail).

- Le serveur d’inférence NVIDIA Triton est l’un des projets open source les plus populaires de l’entreprise. Il permet aux utilisateurs de paclager et de déployer n’importe quel modèle, quel que soit le framework d’IA sur lequel il a été entraîné.

- NVIDIA TensorRT est une bibliothèque d’inférence de Deep Learning hautes performances qui inclut des optimisations du temps d’exécution et du modèle afin d’offrir une inférence à faible latence et à haut débit pour les applications de production.

Disponible sur toutes les principales places de marché cloud, la plateforme logicielle NVIDIA AI Enterprise inclut toutes ces solutions et offre assistance, stabilité, facilité de gestion et sécurité pour les entreprises.

La plateforme d’inférence de l’IA de NVIDIA est indépendante de tout framework et permet aux entreprises de réaliser des économies en matière de productivité, de développement, d’infrastructure et de coûts d’installation. L’utilisation des technologies NVIDIA permet également augmenter les revenus de l’entreprise en aidant à éviter les temps d’arrêt et les transactions frauduleuses, en augmentant les taux de conversion des achats en ligne et en générant de nouvelles sources de revenus basées sur l’IA.

Inférence de LLM basée sur le Cloud

Pour faciliter le déploiement des LLM, NVIDIA a collaboré étroitement avec tous les principaux fournisseurs de services cloud pour s’assurer que la plateforme d’inférence de NVIDIA puisse être déployée en toute transparence dans le cloud avec un minimum de code requis, voire sans code. NVIDIA NIM est intégré à des services pensés pour le Cloud, tels que :

- Amazon SageMaker AI, Amazon Bedrock Marketplace, Amazon Elastic Kubernetes Service

- Vertex AI de Google Cloud, Google Kubernetes Engine

- Microsoft Azure AI Foundry (bientôt disponible), Azure Kubernetes Service

- Outils de Data Science d’Oracle Cloud Infrastructure, Oracle Cloud Infrastructure, Kubernetes Engine

Qui plus est, le serveur d’inférence NVIDIA Triton est totalement intégré à tous les principaux fournisseurs de services Cloud, ce qui facilite le déploiement d’inférences personnalisées.

Par exemple, lors du déploiement de NVIDIA Triton sur la plateforme de Data Science d’OCI, le simple fait d’activer un commutateur dans les arguments de ligne de commande pendant le déploiement du modèle lance instantanément un point de terminaison d’inférence NVIDIA Triton.

De la même manière, Azure Machine Learning permet aux utilisateurs de déployer NVIDIA Triton soit sans code via Azure Machine Learning Studio, soit avec code complet via Azure Machine Learning CLI. AWS propose un déploiement en un clic pour NVIDIA NIM à partir de SageMaker Marketplace, tandis que Google Cloud offre une option de déploiement en un clic sur Google Kubernetes Engine (GKE). Google Cloud propose une option de déploiement en un clic sur Google Kubernetes Engine, tandis qu’AWS offre NVIDIA Triton sur ses conteneurs AWS Deep Learning.

La plateforme d’inférence IA de NVIDIA utilise également des méthodes de communication courantes pour fournir des prédictions IA, s’adaptant automatiquement aux besoins croissants et changeants des utilisateurs au sein d’une infrastructure basée sur le Cloud.

De l’accélération des modèles de LLM à l’amélioration des workflows créatifs et à la transformation de la gestion des contrats, la plateforme d’inférence IA de NVIDIA a un impact concret dans tous les secteurs. Découvrez comment la collaboration et l’innovation permettent aux entreprises ci-dessous d’atteindre de nouveaux niveaux d’efficacité et d’évolutivité.

Traiter 400 millions de requêtes de recherche par mois grâce à Perplexity AI

Perplexity AI, un moteur de recherche basé sur l’IA, traite plus de 435 millions de requêtes par mois. Chaque requête représente plusieurs demandes d’inférence IA. Pour répondre à cette demande, l’équipe Perplexity AI s’est tournée vers les GPU NVIDIA H100, les serveurs d’inférence Triton et TensorRT-LLM.

Prenant en charge plus de 20 modèles d’IA, y compris les variantes Llama 3 telles que 8B et 70B, Perplexity traite diverses tâches telles que la recherche, la synthèse et les questions-réponses. Grâce à l’utilisation de modèles de classification plus petits pour acheminer les tâches vers des groupes GPU gérés par NVIDIA Triton, l’entreprise fournit un service réactif et rentable dans le respect de contrats de niveau de service stricts.

Grâce au parallélisme des modèles, qui répartit les LLM entre les GPU, Perplexity a pu diviser ses coûts par trois tout en conservant une faible latence et une grande précision. Ce framework de bonnes pratiques montre comment les équipes informatiques peuvent répondre aux demandes croissantes en matière d’IA, optimiser le coût total de possession et évoluer en toute transparence grâce au calcul accéléré NVIDIA.

Réduire les temps de réponse avec Recurrent Drafter (ReDrafter)

Les avancées de la recherche open source contribuent à démocratiser l’inférence IA. Récemment, NVIDIA a intégré Redrafter, une approche open source du décodage spéculatif publiée par Apple, dans NVIDIA TensorRT-LLM.

ReDrafter utilise des modules « brouillons » plus petits pour prédire les jetons en parallèle, qui sont ensuite validés par le modèle principal. Cette technique réduit considérablement les temps de réponse des LLM, en particulier pendant les périodes de faible trafic.

Transformer la gestion des contrats avec Docusign

Docusign, leader dans la gestion des contrats numériques, s’est tourné vers NVIDIA pour optimiser sa plateforme intelligente de gestion des accords. Avec plus de 1,5 million de clients dans le monde, Docusign avait besoin d’optimiser son débit et de gérer ses dépenses d’infrastructure tout en fournissant des informations basées sur l’IA.

NVIDIA Triton a fourni une plateforme d’inférence unifiée pour tous les frameworks, accélérant ainsi la mise sur le marché et stimulant la productivité en transformant les données d’accord en informations exploitables. L’adoption de la plateforme d’inférence de NVIDIA par Docusign souligne l’impact positif d’une infrastructure d’IA évolutive sur l’expérience client et l’efficacité opérationnelle.

« NVIDIA Triton nous facilite la vie », s’enthousiasme Alex Zakhvatov, chef de produit senior chez Docusign. « Nous n’avons plus besoin de déployer des serveurs d’inférence sur mesure et spécifiques à chaque framework pour nos modèles d’IA. Nous exploitons Triton comme serveur d’inférence unifié pour tous les frameworks d’IA et nous l’utilisons également pour identifier le scénario de production le plus adapté afin d’optimiser les coûts et les performances de nos efforts d’ingénierie. »

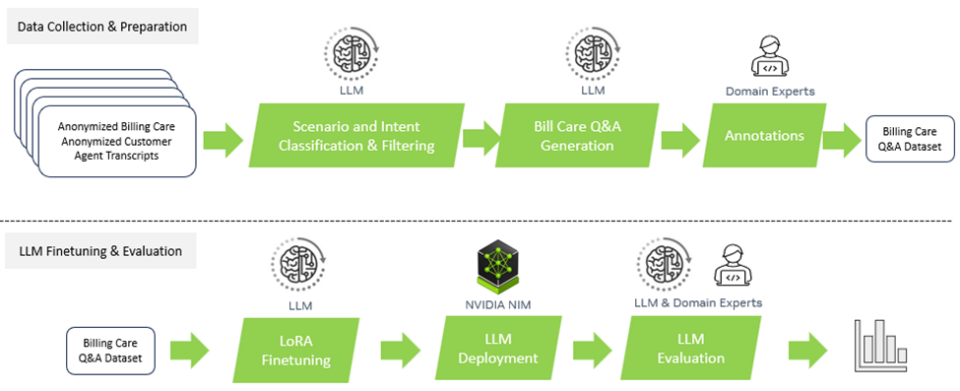

Améliorer le service client dans le secteur des télécommunications avec Amdocs

Amdocs, l’un des principaux fournisseurs de logiciels et de services destinés aux opérateurs de télécommunications et aux fournisseurs de médias, a développé amAIz, une plateforme d’IA générative spécifique au domaine des télécommunications, qui constitue un framework ouvert, sécurisé, rentable et indépendant des modèles LLM. Amdocs utilise NVIDIA DGX Cloud et le logiciel NVIDIA AI Enterprise pour fournir des solutions basées sur des LLM disponibles dans le commerce et des modèles adaptés à un domaine. De quoi permettre aux fournisseurs de services de développer et de déployer des applications d’IA générative pour les entreprises.

Grâce à NVIDIA NIM, Amdocs a réduit jusqu’à 60 % le nombre de jetons consommés pour les cas d’utilisation déployés dans le prétraitement des données et jusqu’à 40 % dans l’inférence, tout en offrant le même niveau de précision avec un coût par jeton nettement inférieur, en fonction de divers facteurs et des volumes utilisés. Cette collaboration a également réduit la latence des requêtes d’environ 80 %, garantissant ainsi aux utilisateurs finaux des réponses en temps quasi réel. Cette accélération améliore l’expérience utilisateur dans les domaines du commerce, du service client, des opérations et bien plus encore.

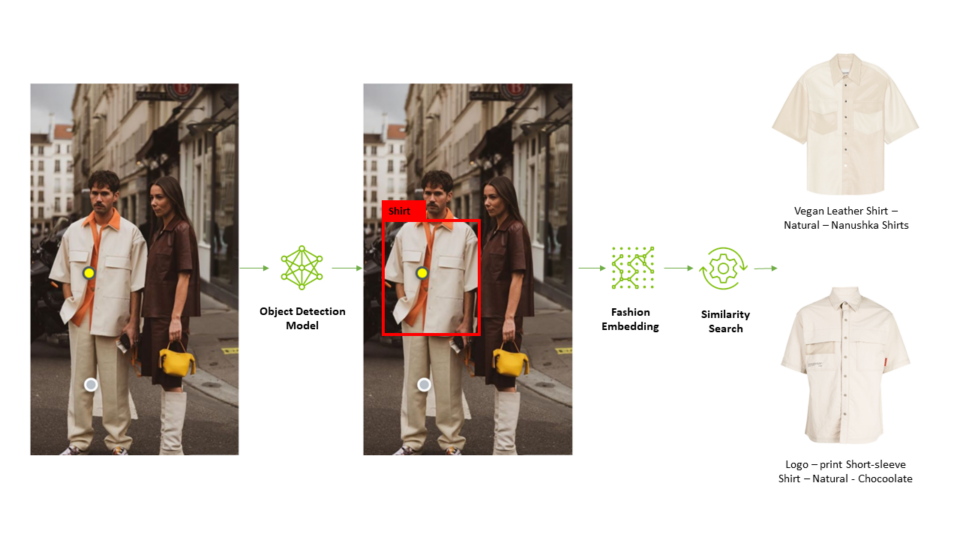

Révolutionner le commerce de détail grâce à l’IA sur Snap

Acheter la tenue parfaite n’a jamais été aussi facile, grâce à la fonctionnalité Screenshop de Snap. Cet outil intégré à Snapchat et basé sur l’IA aide les utilisateurs à trouver des articles de mode visibles sur les photos. NVIDIA Triton a joué un rôle essentiel dans la création du pipeline de Screenshop et son traitement des images à l’aide de plusieurs frameworks, notamment TensorFlow et PyTorch.

En consolidant son pipeline en une seule plateforme de service d’inférence, Snap a considérablement réduit ses délais et ses coûts de développement tout en facilitant le déploiement de modèles mis à jour pour une expérience utilisateur fluide et basée sur l’IA.

« Nous ne voulions pas déployer des plateformes de service d’inférence dédiées pour notre pipeline Screenshop, une plateforme TF-serving pour TensorFlow et une plateforme TorchServe pour PyTorch. », explique Ke Ma, ingénieur en apprentissage automatique chez Snap. « Le fait que Triton soit compatible avec n’importe quel framework et prenne en charge plusieurs backends, tels que TensorFlow, PyTorch et ONNX, nous ont convaincus. Nous avons ainsi pu desservir notre pipeline de bout en bout à l’aide d’une seule plateforme de service d’inférence, ce qui réduit nos coûts de service d’inférence et le nombre de jours de développement nécessaires pour mettre à jour nos modèles en production. » Après le lancement réussi du service Screenshop sur NVIDIA Triton, M. Ma et son équipe se sont tournés vers NVIDIA TensorRT pour améliorer encore les performances de leur système. En appliquant les paramètres par défaut de NVIDIA TensorRT pendant le processus de compilation, l’équipe de Screenshop a immédiatement triplé son débit, ce qui a permis de réduire les coûts de 66 %.

La liberté financière basée sur l’IA avec Wealthsimple

Wealthsimple, une plateforme d’investissement canadienne qui gère plus de 30 milliards de dollars d’actifs, a redéfini son approche de l’apprentissage automatique grâce à la plateforme d’inférence de l’IA de NVIDIA. En standardisant son infrastructure, Wealthsimple a réduit les temps de livraison des modèles pour passer de plusieurs mois à moins de 15 minutes. De quoi éliminer les temps d’arrêt et permettre aux équipes d’offrir l’apprentissage automatique en tant que service.

En adoptant NVIDIA Triton et en exécutant ses modèles via AWS, Wealthsimple a atteint une disponibilité de 99,999 %, garantissant ainsi des prévisions fiables pour plus de 145 millions de transactions par an. Cette transformation montre comment une infrastructure d’IA robuste peut révolutionner les services financiers.

« La plateforme d’inférence de l’IA de NVIDIA a été la clé de voûte de notre réussite en apprentissage automatique. Elle a révolutionné le déploiement de nos modèles, réduit les temps d’arrêt et nous permet d’offrir un service inégalé à nos clients », précise Mandy Gu, responsable principale du développement logiciel chez Wealthsimple.

Améliorer les workflows de création avec Let’s Enhance

La génération d’images basée sur l’IA a transformé les workflows de création et peut être appliquée à des cas d’utilisation en entreprise tels que la création de contenu personnalisé et d’arrière-plans imaginatifs pour les visuels marketing. Les modèles de diffusion sont des outils puissants pour améliorer les flux de travail créatifs, mais ils peuvent être gourmands en calcul.

Let’s Enhance, une startup pionnière en IA, a choisi la plateforme d’inférence de l’IA de NVIDIA pour optimiser ses workflows à l’aide du modèle Stable Diffusion XL en production.

AI Photoshoot, le nouveau produit de Let’s Enhance, utilise le modèle SDXL pour transformer des photos de produits ordinaires en magnifiques ressources visuelles pour les sites web de e-commerce et les campagnes marketing.

Grâce à la prise en charge de divers frameworks et backends par NVIDIA Triton et à ses fonctionnalités de création de batch dynamique, Let’s Enhance a pu intégrer facilement le modèle SDXL aux pipelines d’IA existants avec une implication minimale des équipes d’ingénierie, qui ont pu à la place se concentrer sur la recherche et le développement.

Accélérer la vision par l’IA basée sur le cloud avec OCI

Oracle Cloud Infrastructure (OCI) a intégré NVIDIA Triton pour donner vie à son service de vision par l’IA et améliorer son débit de prédiction jusqu’à 76 % tout en réduisant sa latence de 51 %. Ces optimisations ont amélioré l’expérience client avec des applications telles que l’automatisation de la facturation des péages pour les agences de transport en commun et la rationalisation de la reconnaissance des factures pour les entreprises internationales.

Grâce aux capacités indépendantes du matériel de Triton, OCI a élargi son portefeuille de services d’IA, en offrant des solutions robustes et efficaces dans tous ses datacenters à travers le monde.

« Notre plateforme d’IA est compatible avec Triton afin de profiter à nos clients », déclare Tzvi Keisar, directeur de la gestion de produits pour le service de Data Science d’OCI qui gère l’apprentissage automatique pour les utilisateurs internes et externes d’Oracle.

Intelligence contextualisée en temps réel et recherche efficace avec Microsoft

Azure offre l’une des sélections les plus vastes et les plus variées de machines virtuelles basées sur et optimisées par les solutions d’IA de NVIDIA. Ces machines virtuelles englobent plusieurs générations de GPU NVIDIA, y compris les systèmes NVIDIA Blackwell et NVIDIA Hopper.

Aujourd’hui, cette collaboration historique en ingénierie continue puisque les GPU NVIDIA et NVIDIA Triton contribuent à accélérer l’inférence de l’IA dans Copilot pour Microsoft 365. Microsoft 365 Copilot est accessible via une touche de clavier dédiée sur les PC Windows et combine la puissance des LLM à celle des données d’entreprise propriétaires pour offrir une intelligence contextualisée en temps réel et permettre aux utilisateurs de renforcer leur créativité, leur productivité et leurs compétences.

Microsoft Bing a également utilisé les solutions d’inférence de NVIDIA pour résoudre des problèmes de latence, de coût et de vitesse. En intégrant des techniques de NVIDIA TensorRT-LLM, Microsoft a considérablement amélioré les performances d’inférence de sa fonctionnalité de recherche approfondie qui permet d’obtenir des résultats Web optimisés.

Guide sur la recherche approfondie offert par Microsoft

La recherche visuelle de Microsoft Bing permet aux utilisateurs du monde entier de trouver du contenu à l’aide de photos. Au cœur de cette fonctionnalité se trouve le modèle d’intégration visuelle de Microsoft, TuringMM, qui mappe les images et le texte dans un grand espace partagé. Ses performances sont essentielles dans la mesure où il traite des milliards d’images sur le Web.

Microsoft Bing a optimisé le pipeline TuringMM à l’aide de NVIDIA TensorRT et des bibliothèques d’accélération de NVIDIA, telles que CV-CUDA et nvImageCodec. Ces efforts ont permis de multiplier la vitesse par 5,13 et de réduire considérablement le coût de possession.

Libérer le plein potentiel de l’inférence de l’IA grâce à l’innovation matérielle

Améliorer l’efficacité des charges de travail d’inférence de l’IA est un défi à multiples facettes qui nécessite des technologies innovantes, tant sur le plan matériel que logiciel.

économes en énergie, le calcul accéléré de NVIDIA sur l’architecture NVIDIA Blackwell a en effet divisé par 100 000 l’énergie utilisée par génération de jeton au cours des dix dernières années pour l’inférence de modèles d’IA à plusieurs billions de paramètres.

La superpuce NVIDIA Grace Hopper combine les architectures de CPU NVIDIA Grace et de GPU Hopper à l’aide de NVIDIA NVLink-C2C et offre des améliorations substantielles des performances d’inférence dans tous les secteurs.

Libérer de la valeur pour les annonceurs grâce à l’apprentissage automatique de pointe de Meta Andromeda

Meta Andromeda utilise la superpuce pour récupérer efficacement des publicités personnalisées. En créant des réseaux neuronaux profonds avec une complexité de calcul et un parallélisme accrus, Facebook et Instagram ont amélioré la qualité de leurs publicités de 8 % sur certains segments et celle de leur rappel de 6 %.

Grâce à des modèles de récupération optimisés et à des opérateurs de GPU faible latence, haut débit et sensibles aux E/S mémoire, Andromeda offre une vitesse d’extraction de fonctionnalités 100 fois supérieure à celle des précédents composants basés sur CPU. Cette intégration de l’IA à l’étape de la récupération a permis à Meta de devenir le leader de l’industrie en récupération des publicités et de relever des défis tels que l’évolutivité et la latence pour une meilleure expérience utilisateur et un retour plus élevé sur les dépenses publicitaires.

À mesure que la taille des modèles d’IA de pointe continue de croître, la quantité de calcul nécessaire pour générer chaque jeton augmente également. Les entreprises ont besoin de plusieurs GPU travaillant de concert pour exécuter des LLM de pointe en temps réel. Des outils tels que la bibliothèque de communication collective de NVIDIA, ou NCCL, permettent aux systèmes multi-GPU d’échanger rapidement de grandes quantités de données entre les GPU avec un temps de communication minimal.

Futures innovations en inférence de l’IA

L’avenir de l’inférence de l’IA promet des avancées significatives en matière de performances et de coût.

La combinaison des logiciels NVIDIA, de nouvelles techniques et de matériel plus avancé permettra aux datacenters de gérer des charges de travail de plus en plus complexes et variées. L’inférence de l’IA continuera à faire progresser des secteurs tels que la santé et la finance grâce à des prévisions plus précises, à une prise de décision plus rapide et à de meilleures expériences utilisateur.

Ces tendances étant appelées à évoluer, les entreprises doivent impérativement se tenir informées et exploiter les dernières optimisations en matière d’inférence afin de maximiser leurs investissements et rester compétitives à l’ère de l’IA.

Découvrez comment NVIDIA offre des performances d’inférence révolutionnaires et restez au courant des mises à jour sur les performances d’inférence de l’IA.