L’IA open-source accélère l’innovation dans tous les secteurs, et NVIDIA DGX Spark et DGX Station sont conçus pour aider les développeurs à transformer l’innovation en impact.

NVIDIA a dévoilé aujourd’hui lors du salon CES comment les supercalculateurs d’IA de bureau DGX Spark et DGX Station permettent aux développeurs d’exploiter les derniers modèles d’IA ouverts et révolutionnaires sur un système de bureau local, des modèles à 100 milliards de paramètres sur DGX Spark aux modèles à 1 billion de paramètres sur DGX Station.

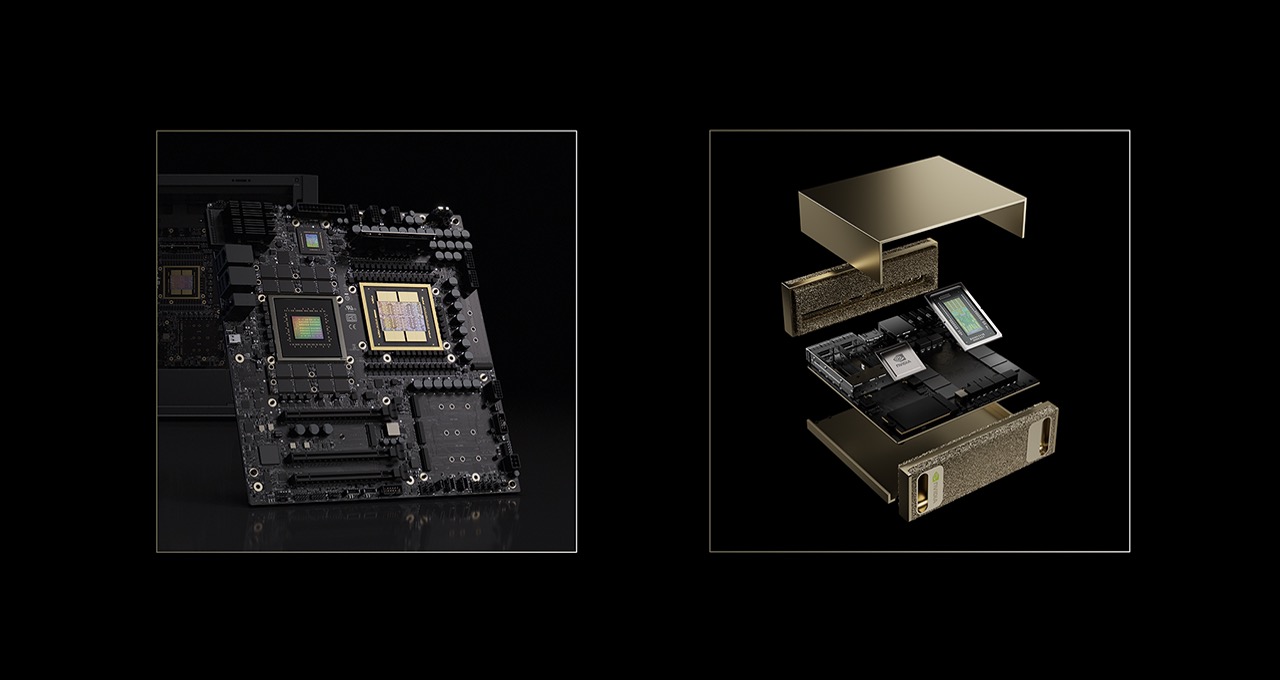

Propulsés par l’architecture NVIDIA Grace Blackwell, avec une grande mémoire unifiée et des performances d’IA au niveau du pétaflop, ces systèmes offrent aux développeurs de nouvelles capacités pour développer localement et s’adapter facilement au cloud.

Faire progresser les performances sur les modèles d’IA open-source.

Une large gamme de modèles ouverts hautement optimisés, qui nécessitaient auparavant un centre de données pour fonctionner, peuvent désormais être accélérés directement sur DGX Spark et DGX Station, grâce aux avancées continues de l’optimisation des modèles et aux collaborations avec la communauté open-source.

Préconfiguré avec le logiciel d’IA de NVIDIA et les bibliothèques NVIDIA CUDA-X, DGX Spark fournit une puissante optimisation plug-and-play pour les développeurs, les chercheurs et les data scientists afin de créer, d’affiner et d’exécuter l’IA.

Spark fournit une base à tous les développeurs pour exécuter les derniers modèles d’IA sur leur bureau ; Station permet aux entreprises et aux laboratoires de recherche d’exécuter des modèles d’IA de pointe à la frontière technologique, plus avancés et à grande échelle. Les systèmes prennent en charge l’exécution des derniers frameworks et modèles open-source, notamment les modèles NVIDIA Nemotron 3 récemment annoncés, directement à partir d’ordinateurs de bureau.

L’architecture NVIDIA Blackwell qui alimente DGX Spark inclut le format de données NVFP4, ce qui permet de compresser les modèles d’IA jusqu’à 70 % et d’augmenter les performances sans perdre l’intelligence.

Les collaborations de NVIDIA avec l’écosystème logiciel open-source, telles que son travail avec llama.cpp, augmentent les performances en moyenne de 35 % lors de l’exécution de modèles d’IA de pointe sur DGX Spark. Llama.cpp comprend également une mise à niveau de qualité de vie qui accélère les délais de chargement du LLM.

La station DGX, avec la superpuce GB300 Grace Blackwell Ultra et 775 GB de mémoire cohérente avec une précision FP4, peut exécuter des modèles avec jusqu’à 1 trillion de paramètres, offrant aux laboratoires d’IA de pointe des capacités de calcul pour des modèles à grande échelle à partir du bureau. Cela inclut une variété de modèles d’IA avancés, notamment Kimi-K2 Thinking, DeepSeek-V3.2, Mistral Large 3, Meta Llama 4 Maverick, Qwen3 et OpenAI gpt-oss-120b.

« NVIDIA GB300 est généralement déployé en tant que système à l’échelle du rack », explique Kaichao You, responsable de la maintenance de vLLM. « Il est donc difficile pour des projets tels que vLLM de tester et de développer directement sur la puissante superpuce GB300. » La station DGX modifie cette dynamique. En fournissant GB300 dans une configuration de bureau compacte au facteur de forme unique, la DGX Station permet à vLLM de tester et de développer des fonctionnalités spécifiques au GB300 à un coût considérablement réduit. Les cycles de développement sont ainsi accélérés et le vLLM peut facilement valider et optimiser en continu contre le GB300. »

« La station DGX offre des capacités GPU de niveau centre de données directement dans ma chambre », a déclaré Jerry Zhou, contributeur communautaire à SGLang. « Il est suffisamment puissant pour servir de très grands modèles tels que Qwen3-235B, tester des frameworks d’entraînement avec de grandes configurations de modèles et développer des noyaux CUDA avec des matrices de taille extrêmement grande, le tout localement sans recourir aux racks de cloud. » La boucle d’itération pour le développement des systèmes et des frameworks est ainsi considérablement raccourcie. »

NVIDIA présentera les capacités de DGX Station en direct au CES, en démontrant :

- Pré-entraînement LLM qui se déplace à la vitesse vertigineuse de 250 000 jetons par seconde.

- Une grande visualisation de données de millions de points de données dans des clusters de catégories. Le workflow de modélisation thématique utilise des techniques et des algorithmes d’apprentissage automatique accélérés par la bibliothèque NVIDIA cuML.

- Visualisation d’énormes bases de données de connaissances avec une grande précision à l’aide de Text-to-Knowledge Graph et de Llama 3.3 Nemotron Super 49B.

Extension des flux de travail d’IA et de créateurs

DGX Spark et Station sont spécialement conçus pour prendre en charge l’ensemble du cycle de vie de développement de l’IA, du prototypage et de l’affinage à l’inférence et à la science des données, pour une large gamme d’applications d’IA spécifiques à un secteur dans les domaines de la santé, de la robotique, de la vente au détail, des flux de travail créatifs et bien plus encore.

Pour les créateurs, les derniers modèles de diffusion et de génération vidéo, notamment les modèles FLUX.2 et FLUX.1 de Black Forest Labs et Qwen-Image d’Alibaba, prennent désormais en charge NVFP4, ce qui réduit l’empreinte mémoire et accélère les performances. Le nouveau modèle vidéo LTX-2 de Lightricks est désormais disponible au téléchargement, notamment des points de contrôle quantifiés NVFP8 pour les GPU NVIDIA, offrant une qualité égale à celle des meilleurs modèles cloud.

Des démonstrations en direct du CES mettent en évidence la façon dont DGX Spark peut décharger des charges de travail de génération vidéo exigeantes à partir d’ordinateurs portables de création, en offrant une accélération 8 fois par rapport à un MacBook Pro haut de gamme avec M4 Max, libérant ainsi les systèmes locaux pour un travail créatif ininterrompu.

La plateforme de modding open-source RTX Remix devrait bientôt permettre aux artistes et aux modders 3D d’utiliser DGX Spark pour créer plus rapidement avec l’IA générative. D’autres démonstrations du CES montrent comment une équipe de mods peut transférer l’ensemble de sa création de ressources vers DGX Spark, libérant ainsi leurs PC pour les mods sans interruption et leur permettant de visualiser les modifications de jeu en temps réel.

Les assistants de codage d’IA transforment également la productivité des développeurs. Au CES, NVIDIA a présenté un assistant de codage CUDA local sur DGX Spark, qui permet aux développeurs de conserver leur code source local et sécurisé, tout en bénéficiant d’un développement d’entreprise assisté par l’IA.

Les leaders de l’industrie valident la transition vers l’IA locale

Alors que la demande augmente en matière d’IA sécurisée et haute performance à l’Edge, DGX Spark gagne en popularité dans l’ensemble du secteur.

Les leaders du logiciel, les innovateurs open-source et les partenaires mondiaux pour les stations de travail adoptent DGX Spark pour alimenter l’inférence locale, les flux de travail intelligents et la génération augmentée par récupération sans la complexité de l’infrastructure centralisée.

Leurs perspectives soulignent la façon dont DGX Spark permet une itération plus rapide, un meilleur contrôle sur les données et la propriété intellectuelle, ainsi que de nouvelles expériences d’IA plus interactives sur l’interface du bureau.

Au CES, NVIDIA montre comment utiliser la puissance de traitement de DGX Spark avec le robot Hugging Face Reachy Mini pour amener les agents d’IA dans le monde réel.

« Les modèles ouverts offrent aux développeurs la liberté de créer l’IA à leur façon, et DGX Spark offre cette puissance directement sur le bureau », a déclaré Jeff Boudier, vice-président des produits chez Hugging Face. « Lorsque vous le connectez à Reachy Mini, vos agents d’IA locaux prennent vie et acquièrent une voix qui leur est propre. » Ils peuvent vous voir, vous écouter et vous répondre avec des mouvements expressifs, transformant la puissante IA en quelque chose avec lequel vous pouvez vraiment interagir. »

Hugging Face et NVIDIA ont publié un guide étape par étape pour la création d’un agent d’IA interactif à l’aide de DGX Spark et de Reachy Mini.

« DGX Spark apporte l’inférence d’IA à la périphérie », a déclaré Ed Anuff, vice-président de la stratégie de plateforme de données et d’IA chez IBM. « Avec OpenRAG sur Spark, les utilisateurs disposent d’une pile RAG complète et autonome au sein d’une boîte : extraction, intégration, récupération et inférence. »

« Pour les entreprises qui ont besoin d’un contrôle total sur la sécurité, la gouvernance et la propriété intellectuelle, NVIDIA DGX Spark offre des performances d’IA de classe pétaflop aux clients de JetBrains », a déclaré Kirill Skrygan, PDG de JetBrains. « Que les clients préfèrent les déploiements Cloud, sur site ou hybrides, l’IA de JetBrains est conçue pour répondre à leurs besoins où qu’ils se trouvent. »

TRINITY, un véhicule intelligent, auto-équilibré, à trois roues et monoplace, conçu pour le transport urbain, sera présenté au CES, au sein duquel il utilisera DGX Spark comme cerveau basé sur l’IA pour l’inférence d’IA de charges de travail de modèles de langage de vision en temps réel et open-source.

« TRINITY représente l’avenir de la micromobilité, où les humains, les véhicules et les agents d’IA travaillent ensemble de manière transparente », a déclaré will.i.am. « Avec NVIDIA DGX Spark en tant que cerveau d’IA, TRINITY fournit des processus conversationnels permettant de suivre des objectifs qui transforment la façon dont les gens interagissent avec la mobilité dans les villes connectées. » Ce sont des cerveaux sur roues, conçus à partir de l’agent. »

Accélérer l’adoption de l’IA par les développeurs

Les manuels DGX Spark aident les développeurs à se lancer rapidement avec des projets d’IA réels. Au CES, NVIDIA enrichit cette bibliothèque avec six nouveaux manuels et quatre mises à jour majeures, couvrant des sujets tels que le dernier modèle NVIDIA Nemotron 3 Nano, l’entraînement robotique, les modèles de langage de vision, l’affinage des modèles d’IA à l’aide de deux systèmes DGX Spark, la génomique et l’analyse financière.

Lorsque la station DGX sera disponible plus tard cette année, de nouveaux manuels seront ajoutés pour permettre aux développeurs de se lancer avec les systèmes NVIDIA GB300.

La prise en charge logicielle NVIDIA AI Enterprise est désormais disponible pour les systèmes DGX Spark et GB10 de fabricants partenaires. Grâce à des bibliothèques, des frameworks et des microservices pour le développement d’applications d’IA et l’installation de modèles, ainsi que des opérateurs et des pilotes pour l’optimisation GPU, NVIDIA AI Enterprise permet une ingénierie et un déploiement de l’IA rapides et fiables. Les licences devraient être disponibles à la fin du mois de janvier.

Disponibilité

DGX Spark et les systèmes fabricants partenaires GB10 sont disponibles auprès d’Acer, Amazon, ASUS, Dell Technologies, GIGABYTE, HP Inc., Lenovo, Micro Center, MSI et PNY.

La station DGX sera disponible auprès d’ASUS, Boxx, Dell Technologies, GIGABYTE, HP Inc., MSI et Supermicro à partir du printemps 2026.

Découvrez DGX Spark dans ce blog technique.

Voir l’avis sur les informations sur les produits logiciels.