Les Data Centers se sont appuyés traditionnellement sur le refroidissement par air, par lequel des systèmes de refroidissement mécaniques font circuler de l’air refroidi pour absorber la chaleur des serveurs et les aider à maintenir des conditions optimales. Cependant, à mesure que le volume des modèles d’IA s’accroît et que l’utilisation des modèles de raisonnement par IA se généralise, il devient de plus en plus difficile et coûteux de maintenir ces conditions optimales, et aussi de plus en plus énergivore.

Alors que les Data Centers fonctionnaient auparavant à 20 kW par rack, les installations hyperscales actuelles peuvent prendre en charge plus de 135 kW par rack, ce qui rend considérablement plus difficile la dissipation de la chaleur générée par les racks haute densité. Pour que les serveurs d’IA maintiennent des performances optimales, il est donc nécessaire d’adopter une nouvelle approche en matière d’efficacité et d’évolutivité.

Le refroidissement liquide est l’une des solutions clés, dans la mesure où il réduit la dépendance envers les réfrigérants et évacue la chaleur plus efficacement, ouvrant ainsi la voie à une nouvelle génération d’infrastructures d’IA hautement performantes et écoénergétiques.

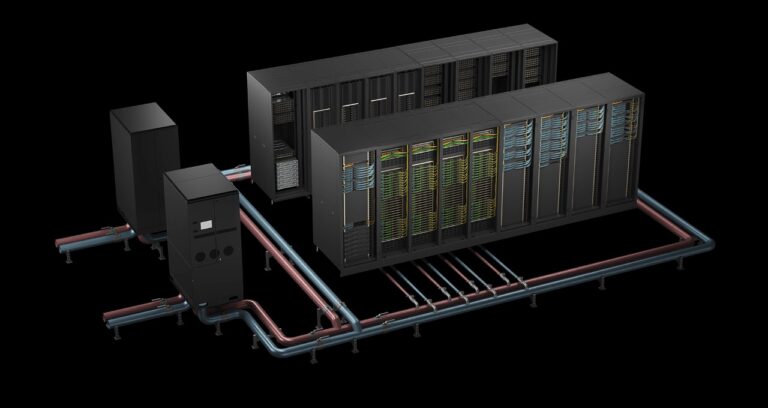

Les systèmes NVIDIA GB200 NVL72 et NVIDIA GB300 NVL72 sont des systèmes à refroidissement liquide à l’échelle du rack conçus pour gérer les tâches d’inférence exigeantes de grands modèles de langage comportant plusieurs billions de paramètres. Leur architecture est également spécifiquement optimisée pour la précision et les performances lors de la mise à l’échelle du temps de test, ce qui en fait le choix idéal pour exécuter des modèles de raisonnement d’IA tout en gérant efficacement les coûts énergétiques et la chaleur.

Permettre une efficacité de l’eau et des économies de coûts sans précédent dans les Data Centers d’IA

Historiquement, le refroidissement à lui seul a représenté jusqu’à 40 % de la consommation d’électricité d’un Data Center, ce qui le désigne comme un des principaux domaines d’amélioration en matière d’efficacité, conduisant à une réduction des dépenses d’exploitation et de la demande en énergie.

Le refroidissement liquide permet de réduire les coûts et la consommation d’énergie en capturant la chaleur directement à la source. Au lieu d’utiliser de l’air comme intermédiaire, le refroidissement liquide appliqué directement sur la puce permet de transférer la chaleur par le biais d’un système de refroidissement technologique en boucle. Cette chaleur est ensuite circulée dans une unité de distribution de réfrigérant à l’aide d’un échangeur de chaleur liquide-liquide, avant de passer par une boucle de refroidissement à l’échelle des installations. L’efficacité supérieure de ce transfert de chaleur permet aux Data Centers et aux usines d’IA de fonctionner efficacement avec de l’eau plus chaude, ce qui réduit ou élimine le besoin de refroidisseurs mécaniques sous une grande variété de climats.

Le système NVIDIA GB200 NVL72 à refroidissement liquide à l’échelle du rack, basé sur la plateforme NVIDIA Blackwell offre des performances exceptionnelles tout en équilibrant les coûts énergétiques et la chaleur. Il offre à chaque rack de serveur une densité de calcul sans précédent, ce qui permet de multiplier les revenus potentiels par 40, le débit par 30, l’efficacité énergétique par 25 et l’efficacité de l’eau par 300 par rapport aux architectures traditionnelles à refroidissement par air. Les nouveaux systèmes NVIDIA GB300 NVL72 basés sur la plateforme Blackwell Ultra offrent un potentiel de revenus 50 fois plus élevé et un débit 35 fois plus élevé tout en étant 30 fois plus écoénergétiques.

Les Data Centers dépensent entre 1,9 et 2,8 millions de dollars par mégawatt (MW) par an, soit près de 500 000 dollars chaque année en coûts d’énergie et d’eau liés au refroidissement. Le déploiement du système GB200 NVL72 à refroidissement liquide permet aux Data Centers hyperscales et aux usines d’IA de réaliser jusqu’à 25 fois plus d’économies, soit une économie annuelle de plus de 4 millions de dollars pour un Data Center hyperscale de 50 MW.

Pour les opérateurs de Data Centers et d’usines d’IA, cela réduit les coûts d’exploitation, améliore les métriques d’efficacité énergétique et pérennise une infrastructure qui optimise efficacement les charges de travail d’IA, sans l’empreinte hydrique non durable des méthodes de refroidissement traditionnelles.

Déplacer la chaleur en dehors du Data Center

À mesure que la densité de calcul augmente et que les charges de travail d’IA génèrent des charges thermiques sans précédent, les Data Centers et les usines d’IA doivent repenser la façon dont ils débarrassent leur infrastructure de cette chaleur. Les méthodes de rejet de chaleur traditionnelles qui prenaient en charge une mise à l’échelle de CPU prévisible ne suffisent plus à elles seules. Il existe aujourd’hui plusieurs options permettant d’extraire la chaleur des installations, mais quatre grandes catégories dominent les déploiements actuels et émergents.

Principales méthodes de refroidissement dans un paysage en pleine évolution

- Refroidisseurs mécaniques : les refroidisseurs mécaniques utilisent un cycle de compression de vapeur pour refroidir l’eau, qui circule ensuite dans le Data Center pour absorber la chaleur. Ces systèmes sont généralement refroidis par air ou par eau, ces derniers étant souvent associés à des tours de refroidissement pour rejeter la chaleur. Si les refroidisseurs sont fiables et efficaces sous une grande variété de climats, ils sont également très énergivores. Dans les installations à l’échelle de l’IA où la consommation d’énergie et la durabilité sont des priorités absolues, la dépendance envers les refroidisseurs peut avoir un impact considérable, tant sur les coûts d’exploitation que sur l’empreinte carbone.

- Refroidissement par évaporation : le refroidissement par évaporation utilise l’évaporation de l’eau pour absorber et éliminer la chaleur. Cela peut être réalisé par des systèmes directs ou indirects, ou des conceptions hybrides. Ces systèmes sont beaucoup plus économes en énergie que les refroidisseurs, mais ils consomment beaucoup d’eau. Dans les grandes installations, ils peuvent consommer des millions de litres d’eau par mégawatt par an. Leurs performances dépendent également du climat, ce qui les rend moins efficaces dans les régions humides ou aux ressources en eau limitées.

- Refroidisseurs secs : les refroidisseurs secs éliminent la chaleur en la transférant entre une boucle liquide fermée et l’air ambiant à l’aide de grandes bobines à ailettes, un peu comme un radiateur automobile. Ces systèmes ne nécessitent pas d’eau et conviennent parfaitement aux installations qui visent à réduire leur consommation d’eau ou fonctionnent sous des climats secs. Cependant, leur efficacité dépend fortement de la température de l’air environnant. Dans des environnements plus chauds, ils peuvent éprouver des difficultés à répondre aux besoins en refroidissement haute densité, sauf s’ils sont associés à des systèmes informatiques à refroidissement liquide capables de tolérer des températures de fonctionnement plus élevées.

- Systèmes à réfrigérant pompé : les systèmes à réfrigérant pompé utilisent des réfrigérants liquides pour transférer la chaleur entre le Data Center et des échangeurs de chaleur externes. Contrairement aux refroidisseurs, ces systèmes ne dépendent pas de compresseurs volumineux situés à l’intérieur des installations et fonctionnent sans eau. Cette méthode offre une solution thermodynamiquement efficace, compacte et évolutive qui fonctionne particulièrement bien dans les déploiements situé à l’Edge et les environnements dont les ressources en eau sont limitées. Une manipulation et une surveillance appropriées des réfrigérants sont nécessaires, mais les avantages en matière d’énergie et d’eau sont considérables.

Chacune de ces méthodes offre différents avantages en fonction de facteurs tels que le climat, la densité des racks, la conception des installations et les objectifs de développement durable. À mesure que le refroidissement liquide se généralise et que les serveurs sont conçus pour fonctionner avec de l’eau plus chaude, des stratégies de refroidissement plus efficaces et respectueuses de l’environnement voient le jour. Celles-ci permettent de réduire la consommation d’énergie et d’eau tout en offrant des performances de calcul plus élevées.

Optimiser les Data Centers pour l’infrastructure d’IA

À mesure que les charges de travail d’IA augmentent exponentiellement, les opérateurs repensent la conception des Data Centers en utilisant une infrastructure spécialement conçue pour l’IA hautes performances et l’efficacité énergétique. Qu’il s’agisse de transformer l’ensemble de leur configuration en usines d’IA dédiées ou de mettre à niveau des composants modulaires, l’optimisation des performances d’inférence est essentielle pour gérer les coûts et l’efficacité opérationnelle.

Pour obtenir des performances optimales, les GPU à haute capacité de calcul ne suffisent pas : ils doivent pouvoir communiquer entre eux à la vitesse de la lumière.

NVIDIA NVLink améliore les communications en permettant aux GPU de fonctionner comme une unité de traitement massive et étroitement intégrée pour offrir des performances maximales avec une densité de puissance de 120 kW pour un rack complet. Cette communication étroite à haute vitesse est cruciale dans les tâches d’IA actuelles, car chaque seconde économisée sur le transfert de données peut se traduire par plus de jetons par seconde et des modèles d’IA plus efficaces.

Le refroidissement à air traditionnel éprouve des difficultés à ces niveaux de puissance. Pour suivre le rythme, l’air du Data Center devrait soit être refroidi à des températures inférieures à zéro, soit circuler à la vitesse d’une bourrasque pour évacuer la chaleur, ce qui accroît la difficulté de refroidir des racks denses à l’air seul.

Avec une densité près de 1 000 fois supérieure à celle de l’air, le refroidissement liquide excelle dans l’évacuation de la chaleur, grâce à sa capacité thermique et à sa conductivité thermique supérieures. En éloignant efficacement la chaleur des GPU hautes performances, le refroidissement liquide réduit la dépendance envers les ventilateurs bruyants et gourmands en énergie, ce qui permet d’allouer plus d’énergie au calcul plutôt qu’au refroidissement.

Le refroidissement liquide en action

Les innovateurs de l’industrie exploitent le refroidissement liquide pour réduire les coûts énergétiques, améliorer la densité et stimuler l’efficacité de l’IA :

- L’architecture de référence de Vertiv pour les serveurs NVIDIA GB200 NVL72 réduit la consommation d’énergie annuelle de 25 %, l’espace de rack requis de 75 % et l’empreinte énergétique de 30 %.

- L’infrastructure de refroidissement liquide de Schneider Electric prend en charge jusqu’à 132 kW par rack, ce qui améliore l’efficacité énergétique, l’évolutivité et les performances globales des Data Centers d’IA GB200 NVL72.

- Les unités de distribution de réfrigérant liquide-liquide CHx2000 haute densité de CoolIT Systems fournissent une capacité de refroidissement de 2 MW à une température d’approche de 5 °C, garantissant ainsi aux déploiements GB300 NVL72 une gestion thermique fiable. De plus, les plaques OMNI All-Metal ColdPlates de CoolIT Systems avec technologie brevetée Split-Flow fournissent un refroidissement ciblé de plus de 4 000 W de puissance de dissipation thermique tout en réduisant la perte de pression.

- Les solutions de refroidissement liquide avancées de Boyd, qui s’appuient sur plus 20 ans d’expérience de l’entreprise dans l’industrie du calcul haute performance, incluent des unités de distribution de réfrigérant, des boucles de refroidissement liquide et des plaques froides pour maximiser davantage l’efficacité énergétique et la fiabilité des systèmes pour les charges de travail d’IA à haute densité.

Les fournisseurs de services Cloud adoptent également des innovations de pointe en matière de refroidissement et d’alimentation. Les Data Centers AWS de nouvelle génération dotés de solutions de refroidissement liquide développées conjointement augmentent la puissance de calcul de 12 % et réduisent la consommation d’énergie à hauteur de 46 %, tout en préservant l’efficacité de l’eau.

Refroidir l’infrastructure d’IA du futur

À mesure que l’IA continuera de repousser les limites de l’échelle de calcul, les innovations en matière de refroidissement seront essentielles pour relever les défis de gestion thermique de l’ère post-loi de Moore.

NVIDIA mène cette transformation grâce à des initiatives telles que le programme COOLERCHIPS, une initiative du ministère de l’Énergie des États-Unis visant à développer des Data Centers modulaires avec des systèmes de refroidissement de nouvelle génération qui devraient réduire les coûts d’au moins 5 % et améliorer l’efficacité de 20 % par rapport aux conceptions à refroidissement par air traditionnelles.

À l’avenir, les Data Centers doivent évoluer non seulement pour répondre aux demandes croissantes de l’IA, mais aussi de manière durable, en maximisant l’efficacité énergétique et hydrique tout en minimisant l’impact sur l’environnement. En adoptant des architectures haute densité et un refroidissement liquide avancé, l’industrie ouvre la voie à un avenir plus efficace basé sur l’IA.

Découvrez les solutions d’efficacité énergétique et hydrique de Data Centers révolutionnaires présentées à la NVIDIA GTC 2025 et comment le calcul accéléré favorise un avenir plus efficace grâce à NVIDIA Blackwell.