Depuis sa mise sur le marché, l’architecture NVIDIA Hopper a transformé le paysage de l’IA et du calcul haute performance (HPC) en aidant les entreprises, les chercheurs et les développeurs à relever les défis les plus complexes au monde grâce à des performances plus élevées et à une efficacité énergétique accrue.

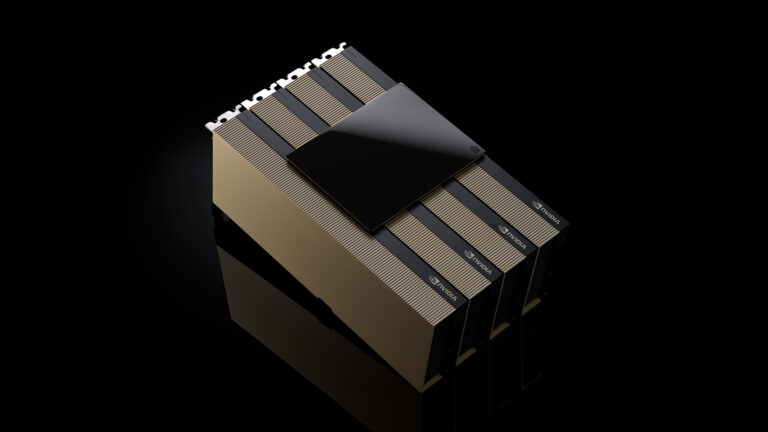

Lors de la conférence Supercomputing 2024, NVIDIA a annoncé la disponibilité du GPU NVIDIA H200 NVL PCIe, le dernier-né de la famille Hopper. Le H200 NVL est idéal pour les groupes à la recherche de racks d’entreprise à faible consommation refroidis par air et à configuration flexible pour leurs datacenters, afin de pouvoir accélérer toutes les charges de travail d’IA et HPC, quelle que soit leur taille.

Selon une enquête récente, environ 70 % des racks d’entreprise consomment 20 kW ou moins et utilisent un refroidissement par air. Les GPU PCIe sont donc essentiels, car ils offrent un déploiement de nœuds précis pour un, deux, quatre ou huit GPU. De quoi permettre aux datacenters d’intégrer davantage de puissance de calcul dans des espaces plus petits. Les entreprises peuvent ainsi continuer à utiliser leurs racks existants et sélectionner le nombre précis de GPU qu’il leur faut.

Les entreprises peuvent utiliser le H200 NVL pour accélérer les applications d’IA et de HPC, tout en améliorant l’efficacité énergétique grâce à une consommation d’énergie réduite. Le H200 NVL est pourvu d’une mémoire 1,5 fois plus importante que le modèle NVIDIA H100 NVL, et d’une bande passante 1,2 fois supérieure. Les entreprises peuvent l’utiliser pour affiner leurs LLM en quelques heures et obtenir des performances d’inférence jusqu’à 1,7 fois plus rapides. Du côté des charges de travail HPC, les performances sont multipliées par 1,3 par rapport au H100 NVL et par 2,5 par rapport à la génération d’architecture NVIDIA Ampere.

Outre la puissance brute du H200 NVL, l’un de ses points forts réside dans sa compatibilité avec la technologie NVIDIA NVLink. La nouvelle génération de NVLink fournit une communication GPU à GPU 7 fois plus rapide que la norme PCIe de cinquième génération, pour fournir des performances plus élevées afin de répondre aux besoins du HPC, de l’inférence des grands modèles de langage et du réglage de précision.

Le NVIDIA H200 NVL est associé à de puissants outils logiciels qui permettent aux entreprises d’accélérer les applications d’IA et de HPC. Il est fourni avec un abonnement de cinq ans à NVIDIA AI Enterprise, une plateforme logicielle pensée pour le cloud et utilisée pour développer et déployer l’IA de production. NVIDIA AI Enterprise inclut les microservices NVIDIA NIM pour un déploiement sécurisé et fiable de l’inférence des modèles d’IA à hautes performances.

Les entreprises exploitent la puissance du H200 NVL

Avec le H200 NVL, NVIDIA offre aux entreprises une plateforme complète pour développer et déployer leurs charges de travail d’IA et de HPC.

Les clients constatent un impact significatif sur de nombreux cas d’utilisation d’IA et de HPC dans tous les secteurs, comme les agents d’IA visuelle et les chatbots pour le service client, les algorithmes de trading pour la finance, l’imagerie médicale pour une meilleure détection des anomalies dans le secteur de la santé, la reconnaissance de schémas en fabrication et l’imagerie sismique pour les organisations scientifiques fédérales.

Dropbox exploite le calcul accéléré de NVIDIA pour ses services et son infrastructure.

« Dropbox gère de grandes quantités de contenu, ce qui nécessite des capacités d’IA et d’apprentissage automatique avancées », explique Ali Zafar, vice-président de l’infrastructure chez Dropbox. « Nous envisageons de recourir au H200 NVL pour améliorer nos services et apporter plus de valeur ajoutée à nos clients. »

L’Université du Nouveau-Mexique utilise le calcul accéléré de NVIDIA dans diverses applications de recherche et académiques.

« En tant qu’université de recherche publique, notre engagement envers l’IA nous permet d’être à la pointe des avancées scientifiques et technologiques », explique le professeur Patrick Bridges, directeur du UNM Center for Advanced Research Computing. « En passant au H200 NVL, nous pourrons accélérer toute une variété d’applications, notamment des initiatives de Data Science, des recherches en bioinformatique et en génomique, des simulations physiques et astronomiques, des modèles climatiques, et bien plus encore. »

Disponibilité du H200 NVL dans tout l’écosystème

Dell Technologies, Hewlett Packard Enterprise, Lenovo et Supermicro devraient proposer une large gamme de configurations prenant en charge le H200 NVL.

En outre, le H200 NVL sera disponible sur les plateformes d’Aivres, ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, MSI, Pegatron, QCT, Wistron et Wiwynn.

Certains systèmes reposent sur l’architecture modulaire NVIDIA MGX, ce qui permet aux fabricants informatiques de concevoir rapidement et à faible coût une large gamme de modèles d’infrastructures de datacenter.

Les plateformes équipées du H200 NVL seront disponibles auprès des partenaires systèmes de NVIDIA partout dans le monde à partir de décembre. En complément de la disponibilité chez ses principaux partenaires mondiaux, NVIDIA développe également une architecture de référence dédiée aux entreprises pour les systèmes H200 NVL.

L’architecture de référence combinera l’expertise et les principes de conception de NVIDIA, de façon à permettre aux partenaires et aux clients de concevoir et de déployer à grande échelle une infrastructure d’IA à hautes performances basée sur le H200 NVL. Elle inclura notamment des recommandations matérielles et logicielles complètes ainsi que des instructions détaillées sur les configurations optimales pour les serveurs, les clusters et les réseaux. La plateforme Ethernet NVIDIA Spectrum-X optimise les performances réseau.

Les technologies NVIDIA seront présentées dans le showroom du SC24, qui aura lieu au Georgia World Congress Center jusqu’au 22 novembre. Pour en savoir plus, regardez la conférence spéciale de NVIDIA.

Prenez connaissance de notre avis sur les informations relatives aux produits logiciels.