L’IA est à l’origine d’une nouvelle révolution industrielle basée sur les usines d’IA.

Contrairement aux Data Centers traditionnels, les usines d’IA vont au-delà du simple stockage et traitement des données : elles fabriquent de l’intelligence à grande échelle en transformant les données brutes en informations en temps réel. Pour les entreprises et les pays du monde entier, cela signifie un délai de rentabilisation beaucoup plus court, c’est-à-dire que l’IA passe du statut d’investissement à long terme à celui de moteur immédiat d’avantage concurrentiel. Les entreprises qui investissent aujourd’hui dans des usines d’IA conçues pour un objectif spécifique seront à la pointe de l’innovation, de l’efficacité et de la différenciation demain.

Alors qu’un Data Center traditionnel gère généralement une grande variété de charges de travail et est conçu pour l’informatique générale, les usines d’IA sont optimisées pour créer de la valeur à partir de l’IA. Elles orchestrent l’ensemble du cycle de vie de l’IA, de l’ingestion des données à l’entraînement, en passant par l’affinage et, surtout, l’inférence à grande échelle.

L’intelligence n’est pas un sous-produit, mais le produit principal des usines d’IA. Cette intelligence est mesurée par le débit des jetons d’IA, c’est-à-dire les prédictions en temps réel à l’origine des décisions, de l’automatisation et de nouveaux services.

Les Data Centers traditionnels ne disparaîtront pas de sitôt, mais le fait qu’ils évoluent en usines d’IA ou qu’ils y soient connectés dépend du modèle d’entreprise de l’entreprise.

Quelle que soit la façon dont les entreprises choisissent de s’adapter, les usines d’IA basées sur la technologie NVIDIA fabriquent déjà de l’intelligence à grande échelle et transforment la façon dont l’IA est créée, affinée et déployée.

Les lois d’échelle stimulent la demande en ressources de calcul

Au cours des dernières années, l’IA s’est concentrée sur l’entraînement de grands modèles. Toutefois, la prolifération récente des modèles de raisonnement IA a propulsé l’inférence au rang de principal moteur de l’économie de l’IA. Trois lois d’échelle clés expliquent pourquoi :

- Mise à l’échelle du pré-entraînement : l’augmentation de la taille des jeux de données et de la taille des paramètres du modèle permet de gagner en intelligence, mais atteindre ce stade nécessite d’importants investissements en experts qualifiés, en conservation des données et en ressources de calcul. Au cours des cinq dernières années, la mise à l’échelle du pré-entraînement a multiplié les besoins en calcul par 50 millions. Cependant, une fois qu’un modèle est entraîné, les obstacles à sa réutilisation par d’autres sont considérablement réduits.

- Mise à l’échelle du post-entraînement : l’affinage des modèles d’IA pour des applications réelles spécifiques nécessite 30 fois plus de ressources de calcul pendant l’inférence de l’IA que le pré-entraînement. À mesure que les entreprises adaptent les modèles existants à leurs besoins spécifiques, la demande totale en infrastructure d’IA explose.

- Mise à l’échelle du temps de test (aussi appelée réflexion longue) : les applications d’IA avancées, telles que l’IA agentique ou physique, nécessitent un raisonnement itératif, c’est-à-dire que les modèles explorent plusieurs réponses possibles avant de sélectionner la meilleure. Cela consomme jusqu’à 100 fois plus de ressources de calcul que l’inférence classique.

Les Data Centers traditionnels ne sont pas conçus pour cette nouvelle ère de l’IA. Les usines d’IA sont spécialement conçues pour optimiser et prendre en charge cette énorme demande en ressources de calcul et représentent ainsi une solution idéale pour l’inférence et le déploiement de l’IA.

Transformer les industries et les économies grâce aux jetons

Les gouvernements et les entreprises du monde entier s’empressent de construire des usines d’IA pour stimuler la croissance économique, l’innovation et l’efficacité.

L’Entreprise commune pour le calcul à haute performance européen (EuroHPC) a récemment annoncé son intention de construire sept usines d’IA en collaboration avec 17 pays membres.

Cela fait suite à une vague d’investissements dans les usines d’IA dans le monde entier, à l’heure où les entreprises et les pays accélèrent la croissance économique basée sur l’IA dans tous les secteurs et toutes les parties du monde :

- Inde : Yotta Data Services s’est associé à NVIDIA pour lancer la plateforme Shakti Cloud et contribuer à démocratiser l’accès à des ressources GPU avancées. En intégrant le logiciel NVIDIA AI Enterprise avec des outils open source, Yotta fournit un environnement qui simplifie le développement et le déploiement de l’IA.

- Japon : les principaux fournisseurs de Cloud, notamment GMO Internet, Highreso, KDDI, Rutilea et SAKURA Internet, développent une infrastructure d’IA basée sur la technologie NVIDIA pour transformer des secteurs tels que la robotique, l’automobile, la santé et les télécommunications.

- Norvège : Telenor a lancé une usine d’IA basée sur la technologie NVIDIA pour accélérer l’adoption de l’IA dans toute la région nordique, en mettant l’accent sur le perfectionnement des compétences de la main-d’œuvre et la durabilité.

Ces initiatives soulignent une réalité mondiale : les usines d’IA sont en train de devenir des infrastructures nationales essentielles, au même titre que les télécommunications et l’énergie.

À l’intérieur d’une usine d’IA : c’est là où l’intelligence est fabriquée

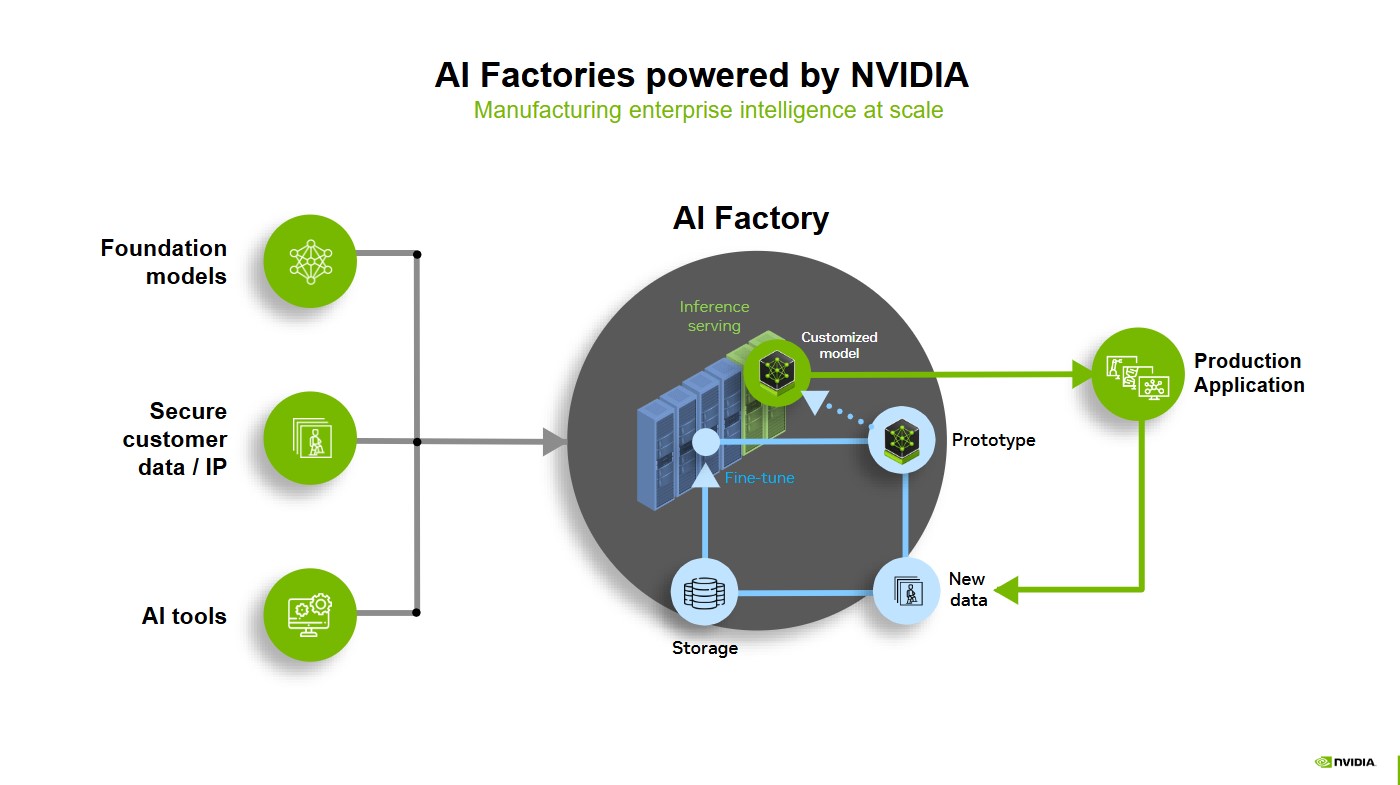

Les modèles de base, les données client sécurisées et les outils d’IA fournissent les matières premières nécessaires aux usines d’IA, dans lesquelles le service d’inférence, le prototypage et l’affinage façonnent de puissants modèles personnalisés prêts à être mis en production.

Lorsque ces modèles sont déployés dans des applications réelles, ils apprennent en permanence à partir de nouvelles données, qui sont stockées, affinées et renvoyées au système à l’aide d’un volant de données. Ce cycle d’optimisation garantit une IA adaptable, efficace et améliorée en permanence, ce qui favorise l’intelligence de l’entreprise à une échelle sans précédent.

L’avantage des usines d’IA avec la pile complète NVIDIA AI

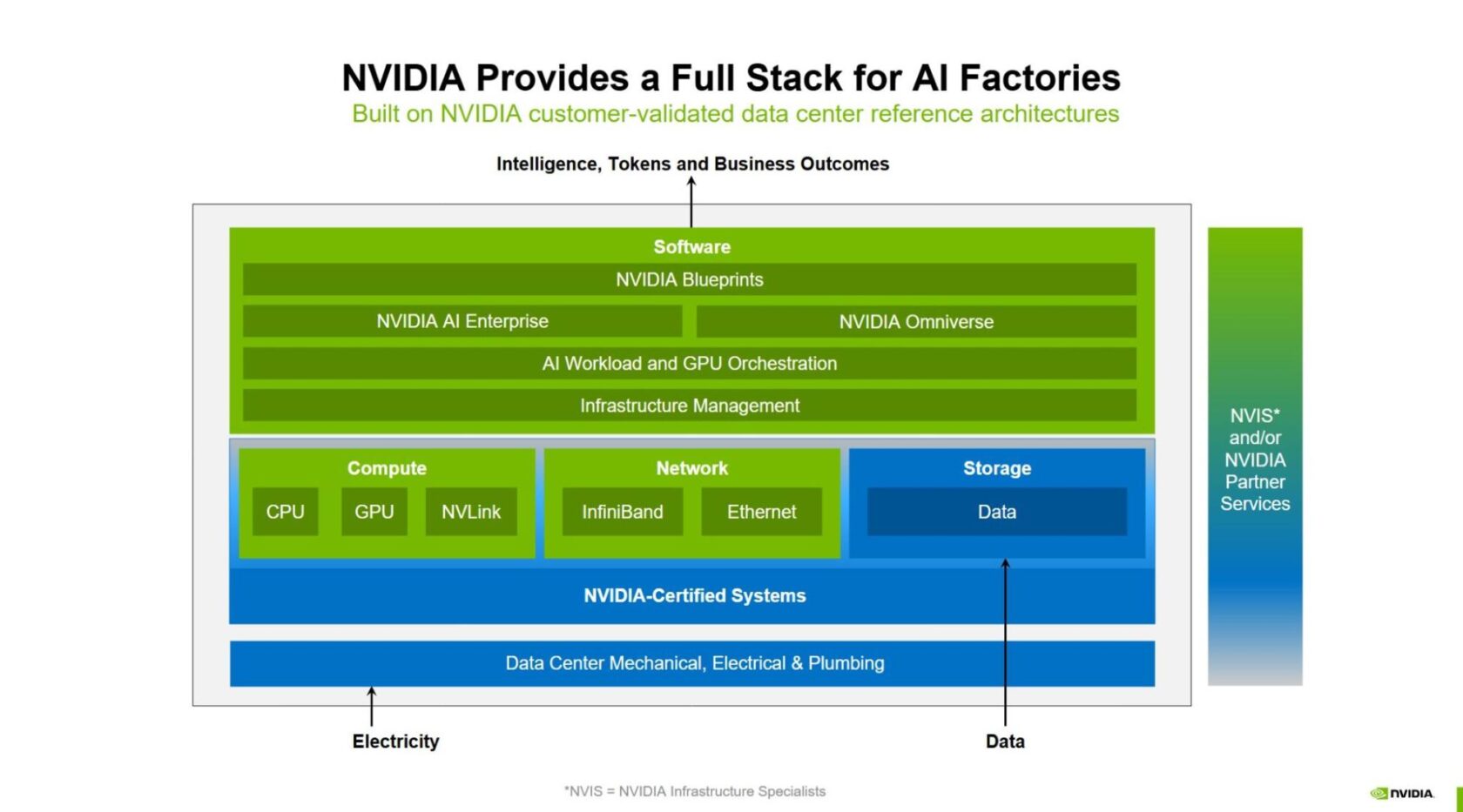

NVIDIA offre une usine d’IA complète et intégrée où chaque couche, du processeur au logiciel, est optimisée pour l’entraînement, l’affinage et l’inférence à grande échelle. Cette approche complète garantit aux entreprises la possibilité de déployer des usines d’IA rentables, hautes performances et pérennes pour la croissance exponentielle de l’IA.

Conjointement avec ses partenaires écosystème, NVIDIA a créé les fondements de l’usine d’IA complète, offrant ainsi :

- De puissantes performances de calcul

- Une mise en réseau avancée

- Une gestion de l’infrastructure et orchestration des charges de travail

- Le plus grand écosystème d’inférence de l’IA

- Des plateformes de stockage et de données

- Des plateformes pour la conception et l’optimisation

- Des architectures de référence

- Un déploiement flexible pour chaque entreprise

De puissantes performances de calcul

Le cœur de toute usine d’IA réside dans sa puissance de calcul. De NVIDIA Hopper à NVIDIA Blackwell, NVIDIA fournit le calcul accéléré le plus puissant au monde pour cette nouvelle révolution industrielle. La solution GB300 NVL72 à l’échelle du rack basée sur la technologie NVIDIA Blackwell Ultra permet aux usines d’IA de multiplier par jusqu’à 50 le raisonnement de l’IA, établissant ainsi une nouvelle norme en matière d’efficacité et d’évolutivité.

NVIDIA DGX SuperPOD est l’exemple parfait d’une usine d’IA clé en main pour les entreprises et intègre le meilleur du calcul accéléré NVIDIA. NVIDIA DGX Cloud propose une usine d’IA qui associe les capacités de calcul accéléré NVIDIA à de hautes performances dans le Cloud.

Nos partenaires partout dans le monde développent des usines d’IA complètes pour leurs clients basées sur le calcul accéléré NVIDIA, avec désormais les solutions à l’échelle du rack NVIDIA GB200 NVL72 et GB300 NVL72.

Mise en réseau avancée

Le transfert d’intelligence à grande échelle nécessite une connectivité fluide et hautement performante à travers l’ensemble de la pile technologique de l’usine IA. NVIDIA NVLink et le commutateur NVLink permettent une communication multi-GPU à haute vitesse et accélèrent ainsi le mouvement des données au sein et entre les nœuds.

Les usines d’IA ont également besoin d’une infrastructure réseau robuste. Les plateformes de mise en réseau NVIDIA Quantum InfiniBand, NVIDIA Spectrum-X Ethernet et NVIDIA BlueField minimisent les goulets d’étranglement et garantissent ainsi un échange de données efficace et haut débit entre d’énormes clusters de GPU. Cette intégration de bout en bout est essentielle pour mettre à l’échelle les charges de travail d’IA jusqu’à plusieurs millions de GPU, afin d’obtenir des performances révolutionnaires en matière d’entraînement et d’inférence.

Gestion de l’infrastructure et orchestration des charges de travail

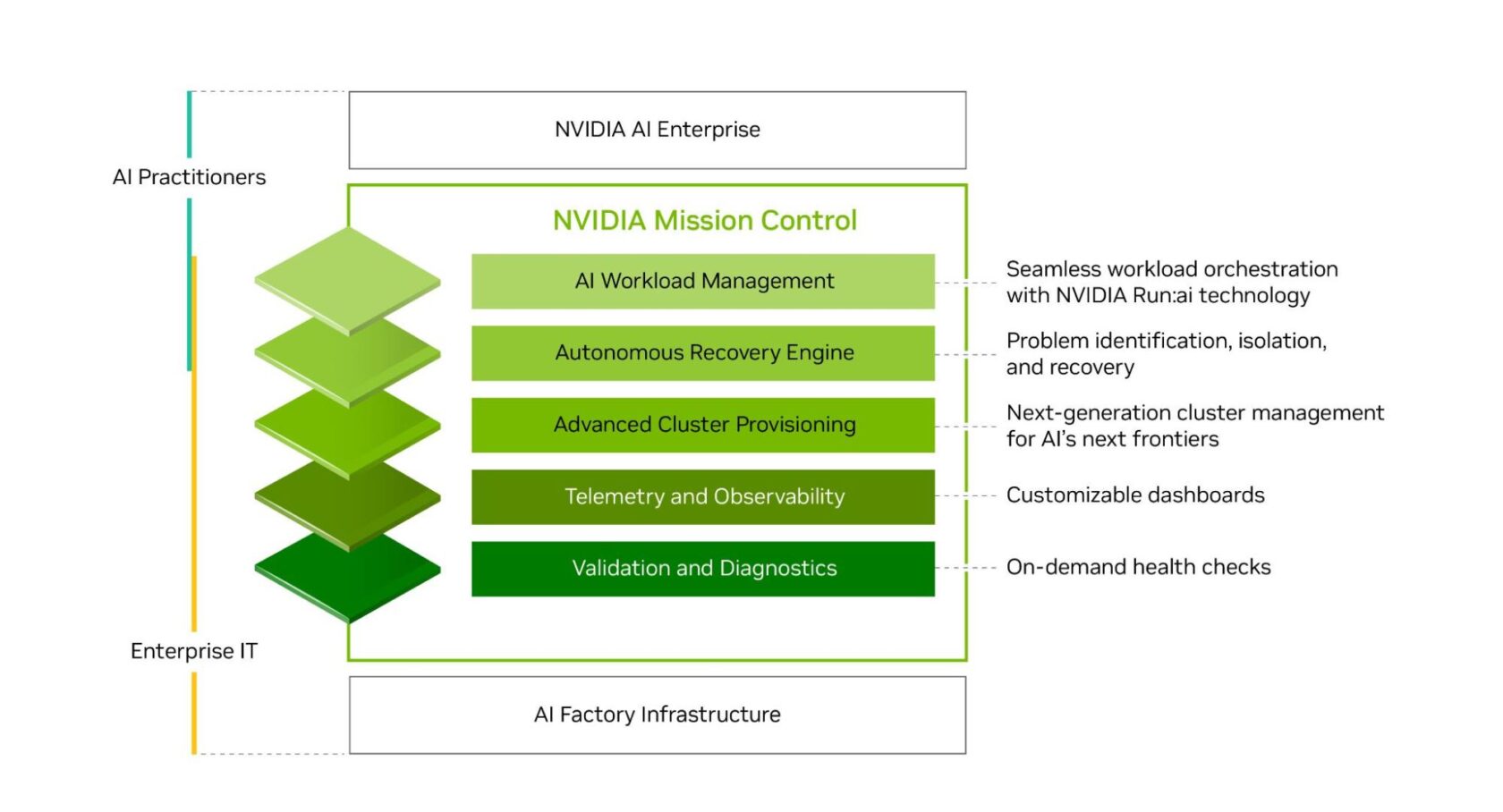

Les entreprises ont besoin d’un moyen d’exploiter la puissance de l’infrastructure d’IA avec l’agilité, l’efficacité et l’évolutivité d’un hyperscaler, mais sans les coûts, la complexité et l’expertise informatique qui y sont associés.

Grâce à NVIDIA Run:ai, les entreprises peuvent facilement orchestrer les charges de travail d’IA et gérer les GPU, afin d’optimiser l’utilisation des ressources tout en accélérant l’expérimentation par l’IA et l’évolutivité des charges de travail. Le logiciel NVIDIA Mission Control inclut la technologie NVIDIA Run:ai et simplifie l’exploitation des usines d’IA, des charges de travail à l’infrastructure, tout en fournissant une intelligence complète pour une infrastructure extrêmement résiliente.

Le plus grand écosystème d’inférence de l’IA

Les usines d’IA ont besoin des bons outils pour transformer les données en intelligence. La plateforme d’inférence de l’IA de NVIDIA fournit la suite de bibliothèques d’accélération de l’IA et de logiciels optimisés la plus complète de l’industrie. Elle englobe l’écosystème NVIDIA TensorRT, NVIDIA Dynamo et les microservices NVIDIA NIM, eux-mêmes partie intégrante (d’ores et déjà ou bientôt) de la plateforme logicielle NVIDIA AI Enterprise. Elle offre des performances d’inférence maximales, une latence ultra-faible et un débit élevé.

Plateformes de stockage et de données

Les données sont au cœur des applications d’IA, mais la quantité et la complexité croissantes des données d’entreprise les rendent souvent trop coûteuses et chronophages pour les exploiter efficacement. Pour réussir à l’ère de l’IA, les entreprises doivent exploiter le plein potentiel de leurs données.

La plateforme de données d’IA de NVIDIA est un modèle de référence personnalisable afin de développer une nouvelle classe d’infrastructures d’IA pour les charges de travail d’inférence de l’IA exigeantes. Nos partenaires de stockage certifié NVIDIA collaborent avec NVIDIA afin de créer des plateformes de données d’IA personnalisées capables d’exploiter les données d’entreprise pour raisonner et répondre à des requêtes complexes.

Modèles pour la conception et l’optimisation

Les équipes peuvent utiliser le modèle NVIDIA Omniverse pour la conception et l’exploitation d’usines IA afin de concevoir et d’optimiser ces dernières.. Ce modèle permet aux ingénieurs de concevoir, de tester et d’optimiser l’infrastructure des usines d’IA avant de les déployer à l’aide de jumeaux numériques. Ce modèle réduit les risques et l’incertitude et permet d’éviter les interruptions coûteuses ; un facteur essentiel pour les opérateurs d’usines d’IA.

Chaque journée de panne dans une usine d’IA de 1 gigawatt peut se chiffrer à plus de 100 millions d’euros. Ce modèle accélère le déploiement et garantit la résilience opérationnelle en résolvant en amont les problèmes complexes et en permettant aux équipes informatiques, mécaniques, électriques, énergétiques et réseau de travailler en parallèle.

Architectures de référence

Les architectures de référence de NVIDIA Enterprise et des partenaires Cloud de NVIDIA fournissent une feuille de route aux partenaires pour concevoir et déployer des usines d’IA. Elles aident les entreprises et les fournisseurs Cloud à développer une infrastructure d’IA évolutive, hautes performances et sécurisée basée sur des systèmes certifiés NVIDIA via la pile logicielle NVIDIA AI et notre écosystème de partenaires.

Chaque couche de l’usine d’IA s’appuie sur un calcul efficace pour répondre aux demandes croissantes de l’IA. Le calcul accéléré de NVIDIA sert de base à l’ensemble de la pile et offre les performances par watt les plus élevées pour garantir une efficacité énergétique optimale des usines d’IA. Grâce à une architecture écoénergétique et à un refroidissement liquide, les entreprises peuvent faire évoluer l’IA tout en contrôlant les coûts énergétiques.

Un déploiement flexible pour chaque entreprise

Grâce aux technologies complètes de NVIDIA, les entreprises peuvent facilement construire et déployer des usines d’IA, en s’adaptant aux modèles de consommation informatique préférés des clients et à leurs besoins opérationnels.

Certaines entreprises optent pour des usines d’IA sur site pour conserver un contrôle total des données et des performances, tandis que d’autres utilisent des solutions Cloud pour plus d’évolutivité et de flexibilité. Beaucoup se tournent également vers leurs partenaires systèmes internationaux pour obtenir des solutions pré-intégrées qui accélèrent le déploiement.

Sur site

NVIDIA DGX SuperPOD est une solution d’infrastructure d’usine d’IA clé en main qui fournit une infrastructure accélérée avec des performances évolutives pour les charges de travail d’entraînement et d’inférence de l’IA les plus exigeantes. Elle combine calcul d’IA, structure réseau, stockage et le logiciel NVIDIA Mission Control. Elle permet aux entreprises de mettre en service leurs usines d’IA en quelques semaines au lieu de plusieurs mois, avec une disponibilité, une résilience et une utilisation optimales.

Des solutions d’usines d’IA sont également proposées via l’écosystème mondial de partenaires technologiques de NVIDIA et de systèmes certifiés NVIDIA. Ils offrent des technologies matérielles et logicielles de pointe, une expertise en systèmes de Data Centers et des innovations en refroidissement liquide pour aider les entreprises à réduire les risques liés à leurs initiatives en IA et à accélérer le retour sur investissement de leurs usines d’IA.

Ces partenaires systèmes internationaux fournissent des solutions complètes basées sur des architectures de référence NVIDIA et intégrées au calcul accéléré de NVIDIA, à la mise en réseau hautes performances et aux logiciels d’IA pour aider les clients à déployer des usines d’IA et à fabriquer de l’intelligence à grande échelle.

Dans le Cloud

Les entreprises à la recherche d’une solution basée sur le Cloud pour leur usine d’IA, peuvent compter sur NVIDIA DGX Cloud, une plateforme unifiée sur les principaux Cloud afin de développer, personnaliser et déployer des applications d’IA. Chaque couche de DGX Cloud est optimisée et entièrement gérée par NVIDIA, pour offrir le meilleur de NVIDIA AI dans le Cloud. La plateforme propose des logiciels conçus pour les entreprises et des clusters contigus à grande échelle chez les principaux fournisseurs Cloud, offrant ainsi des ressources de calcul évolutives idéales pour les charges de travail d’entraînement de l’IA les plus exigeantes.

DGX Cloud inclut également une plateforme d’inférence sans serveur dynamique et évolutive qui offre un débit élevé pour les jetons d’IA dans les environnements hybrides et multi-Cloud. De quoi réduire considérablement la complexité de l’infrastructure et les coûts opérationnels.

En fournissant une plateforme complète qui intègre matériel, logiciels, partenaires de l’écosystème et architectures de référence, NVIDIA aide les entreprises à développer des usines d’IA rentables, évolutives et hautes performances, afin de se préparer à la prochaine révolution industrielle.

En savoir plus sur les usines d’IA de NVIDIA.

Consultez l’avis sur les informations relatives aux produits logiciels.