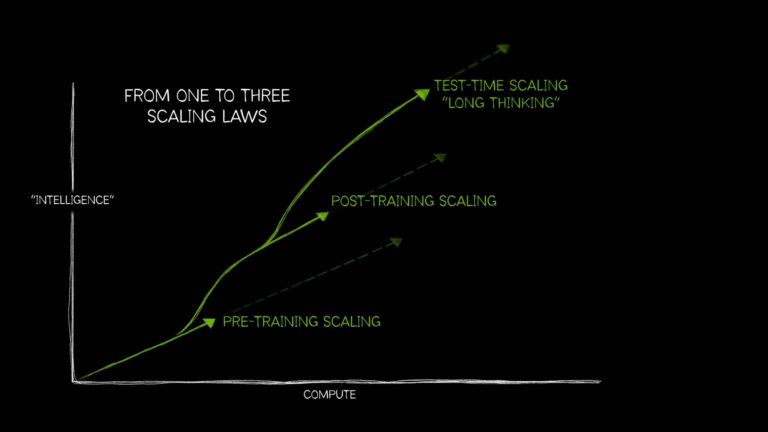

Tout comme il existe des lois empiriques de la nature largement comprises (par exemple, ce qui monte doit redescendre, ou chaque action a une réaction égale et opposée), le domaine de l’IA a longtemps été défini par une idée unique : plus de ressources de calcul, de données d’entraînement et de paramètres pour un meilleur modèle d’IA.

Cependant, l’IA a depuis évolué et a besoin de trois lois distinctes qui décrivent comment l’application des ressources de calcul de différentes façons impacte les performances des modèles. Ensemble, ces lois d’échelle de l’IA (mise à l’échelle du pré-entraînement, mise à l’échelle du post-entraînement et mise à l’échelle du temps de test, également appelée réflexion longue) reflètent la façon dont ce domaine a évolué grâce à la technique afin d’utiliser des capacités de calcul supplémentaires dans une grande variété de cas d’utilisation de l’IA de plus en plus complexes.

L’augmentation récente de la mise à l’échelle du temps de test (appliquer plus de calcul au moment de l’inférence pour améliorer la précision) a permis aux modèles de raisonnement d’IA, une nouvelle classe de grands modèles de langage (LLM) effectuant plusieurs passes d’inférence, de travailler sur des problèmes complexes, tout en décrivant les étapes requises pour accomplir une tâche. La mise à l’échelle du temps de test nécessite d’importantes ressources informatiques pour prendre en charge le raisonnement de l’IA, ce qui stimulera une nouvelle demande en calcul accéléré.

Qu’est-ce que la mise à l’échelle du pré-entraînement ?

La mise à l’échelle du pré-entraînement est la loi originelle du développement de l’IA. Elle a démontré qu’en augmentant la taille de l’ensemble des jeux de données, le nombre de paramètres du modèle et les ressources de calcul, les développeurs pouvaient s’attendre à des améliorations prévisibles de l’intelligence et de la précision des modèles.

Chacun de ces trois éléments (données, taille du modèle, calcul de la machine) est interdépendant. Selon la loi de mise à l’échelle du pré-entraînement décrite dans ce document de recherche, lorsque des modèles plus volumineux sont alimentés avec plus de données, les performances globales des modèles s’améliorent. Pour que cela soit faisable, les développeurs doivent mettre à l’échelle leur capacité de calcul, ce qui crée le besoin de puissantes ressources de calcul accéléré pour exécuter ces charges de travail d’entraînement plus importantes.

Ce principe de mise à l’échelle du pré-entraînement a conduit à de grands modèles qui ont atteint des capacités révolutionnaires. Il a également stimulé des innovations majeures en matière d’architecture de modèles, notamment l’essor de modèles de transformateurs à plusieurs milliards de paramètres, le mélange de modèles d’experts et les nouvelles techniques de formation distribuée, qui exigent tous une puissance de calcul considérable.

La pertinence de la loi de mise à l’échelle du pré-entraînement demeure : les humains continuent de produire des quantités croissantes de données multimodales, et ces précieuses ressources de texte, images, audio, vidéo et d’informations capteurs seront utilisées pour entraîner de puissants futurs modèles d’IA.

Qu’est-ce que la mise à l’échelle du post-entraînement ?

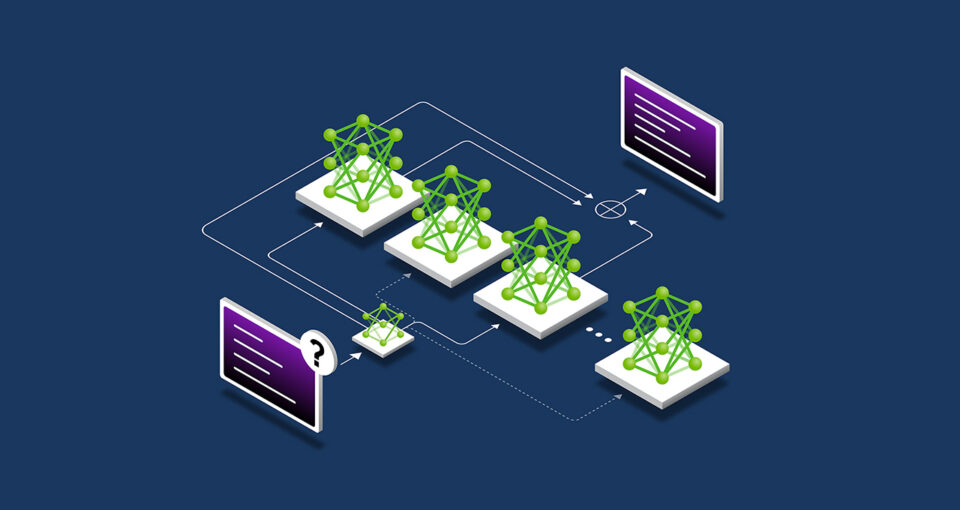

Le préentraînement d’un grand modèle de basenécessite des investissements importants, des experts qualifiés et des jeux de données. Toutefois, lorsqu’une organisation pré-entraîne et lance un modèle, elle abaisse la barrière à l’adoption de l’IA en permettant aux autres utilisateurs d’utiliser leur modèle pré-entraîné comme point de départ pour l’adapter à leurs propres applications.

Ce processus de post-entraînement stimule la demande cumulative supplémentaire en calcul accéléré dans les entreprises et la communauté des développeurs au sens large. Les modèles open source populaires peuvent compter des centaines ou des milliers de modèles dérivés, entraînés dans de nombreux domaines.

Le développement de cet écosystème de modèles dérivés pour une variété de cas d’utilisation pourrait nécessiter environ 30 fois plus de calcul que le pré-entraînement du modèle de base original.

Le développement de cet écosystème de modèles dérivés pour une variété de cas d’utilisation pourrait nécessiter environ 30 fois plus de calcul que le pré-entraînement du modèle de base original.

Les techniques de post-entraînement peuvent encore améliorer la spécificité et la pertinence du modèle pour le cas d’utilisation souhaité d’une organisation. Si le pré-entraînement s’apparente à envoyer un modèle d’IA à l’école pour apprendre des compétences fondamentales, le post-entraînement améliore le modèle en développant des compétences applicables à la tâche prévue. Un LLM, par exemple, pourrait être post-entraîné pour accomplir une tâche comme l’analyse des sentiments, la traduction, ou encore comprendre le jargon d’un domaine spécifique, comme la santé ou le droit.

La loi de mise à l’échelle en post-entraînement postule que les performances d’un modèle pré-entraîné peuvent être améliorées en termes d’efficacité de calcul, de précision ou de spécificité à un domaine grâce à des techniques telles que le l’affinage, l’élagage, la quantification, la distillation, l’apprentissage par renforcement et l’augmentation par données synthétiques.

- Le réglage fin utilise des données d’entraînement supplémentaires pour adapter un modèle d’IA à des domaines et des applications spécifiques. Pour ce faire, on peut utiliser les jeux de données internes de l’organisation ou des exemples d’entrées et de sorties de modèle.

- La distillation nécessite deux modèles d’IA : un grand modèle enseignant complexe et un modèle étudiant léger. La technique de distillation la plus courante, appelée distillation hors ligne, permet au modèle étudiant d’apprendre à imiter les résultats d’un modèle enseignant préentraîné.

- L’apprentissage par renforcement, ou RL, est une technique d’apprentissage automatique qui utilise un modèle de récompense pour entraîner un agent à prendre des décisions adaptées à un cas d’utilisation spécifique. L’agent vise à prendre des décisions qui maximisent les récompenses accumulées au fil du temps via son interaction avec son environnement. Par exemple, un LLM chatbot qui reçoit un renforcement positif chaque fois qu’un utilisateur satisfait lui envoie une réaction positive. Cette technique est connue sous le nom d’apprentissage par renforcement à partir des retours d’humains (ou RLHF pour Reinforcement Learning from Human Feedback). Une autre technique plus récente, l’apprentissage par renforcement à partir des retours d’IA (ou RLAIF pour Reinforcement Learning from AI Feedback), utilise à la place les retours de modèles d’IA pour guider le processus d’apprentissage et simplifier ainsi le travail de post-entraînement.

- L’échantillonnage de type Best-of-n génère plusieurs résultats à partir d’un modèle de langage et sélectionne celui qui a obtenu le score de récompense le plus élevé basé sur un modèle de récompense. Elle est souvent utilisée pour améliorer les résultats de l’IA sans modifier les paramètres du modèle, ce qui constitue une alternative à l’affinage avec l’apprentissage par renforcement.

- Les méthodes de recherche explorent un large éventail de décisions potentielles avant de sélectionner une sortie finale. Cette technique de post-entraînement peut améliorer de manière itérative les réponses du modèle.

Pour accélérer le post-entraînement, les développeurs peuvent utiliser des données synthétiques pour augmenter ou compléter leur jeu de données d’affinage. Compléter les ensembles de données réels par des données générées par l’IA peut aider les modèles à améliorer leur capacité à gérer des cas uniques sous-représentés ou manquants dans les données d’entraînement originales.

Qu’est-ce que la mise à l’échelle du temps de test ?

Les LLM génèrent des réponses rapides aux invites des utilisateurs. Il s’agit d’un processus adapté pour obtenir des réponses correctes à des questions simples, il peut ne pas fonctionner aussi bien lorsque l’utilisateur soumet des requêtes complexes. Répondre à des questions complexes (une capacité essentielle des charges de travail d’IA agentique) nécessite que le LLM raisonne sur la question avant de proposer une réponse.

Un peu comme les humains : lorsqu’on leur demande combien font deux plus deux, ils fournissent une réponse instantanée, sans avoir à discuter des principes fondamentaux de l’addition ou des nombres entiers. Mais si on leur demande d’élaborer dans l’instant un plan commercial susceptible d’accroître les bénéfices de l’entreprise de 10 %, ils vont probablement réfléchir à plusieurs options et fournir une réponse en plusieurs étapes.

La mise à l’échelle du temps de test, également connue sous le nom de réflexion longue, a lieu pendant l’inférence. Au lieu des modèles d’IA traditionnels qui génèrent rapidement une réponse ponctuelle à une question unique, les modèles qui emploient cette technique allouent des ressources de calcul supplémentaires pendant l’inférence afin de réfléchir à plusieurs réponses potentielles avant de fournir la meilleure réponse.

Pour des tâches telles que générer du code personnalisé pour les développeurs, ce processus de raisonnement de l’IA peut prendre plusieurs minutes, voire plusieurs heures, et peut facilement nécessiter plus de 100 fois les ressources de calcul par rapport à une seule passe d’inférence d’un LLM traditionnel pour des requêtes difficiles. LLM qui aurait peu de chances de produire une réponse correcte à un problème complexe dès le premier essai.

Ce processus de raisonnement de l’IA peut prendre plusieurs minutes, voire plusieurs heures, et peut facilement nécessiter plus de 100 fois les ressources de calcul par rapport à une seule passe d’inférence d’un LLM traditionnel pour des requêtes difficiles.

Cette capacité de calcul en temps de test permet aux modèles d’IA d’explorer différentes solutions à un problème et de décomposer des questions complexes en plusieurs étapes, souvent en montrant leur travail à l’utilisateur. Des études ont montré que la mise à l’échelle du temps de test entraine des réponses de meilleure qualité lorsque les modèles d’IA sont confrontés à des invites ouvertes nécessitant plusieurs étapes de raisonnement et de planification.

La méthodologie de calcul en temps de test inclut plusieurs approches, notamment :

- Invite par cheminement :diviser les problèmes complexes en une série d’étapes plus simples.

- Échantillonnage avec vote par majorité : générer plusieurs réponses à la même invite avant de choisir celle qui revient le plus souvent en guise de réponse finale.

- Recherche : explorer et évaluer plusieurs chemins au sein d’une structure de réponses en forme d’arbre.

Les méthodes de post-entraînement comme l’échantillonnage de type best-of-n peuvent également être utilisées pour la réflexion longue pendant l’inférence afin d’optimiser les réponses en fonction des préférences humaines ou d’autres objectifs.

En quoi la mise à l’échelle du temps de test rend possible le raisonnement de l’IA

L’avènement du calcul en temps de test permet à l’IA de générer des réponses utiles, réfléchies et plus précises aux questions complexes et ouvertes des utilisateurs. Ces capacités seront fondamentales pour les tâches de raisonnement détaillées en plusieurs étapes attendues sur les applications d’IA agentique autonome et d’IA physique. Deux domaines capables d’améliorer l’efficacité et la productivité dans tous les secteurs via la création d’assistants très compétents pouvant accélérer le travail des utilisateurs.

Dans le secteur de la santé, les modèles peuvent employer la mise à l’échelle du temps de test pour analyser de grandes quantités de données et deviner la progression d’une maladie, ou encore anticiper des complications potentielles causées par un nouveau médicament en fonction de sa structure chimique. Il est aussi possible de passer en revue une base de données de résultats de tests cliniques pour suggérer des alternatives adaptées à la maladie d’un patient tout en expliquant le raisonnement concernant les arguments pour ou contre différentes études.

Dans le secteur de la vente au détail et de la gestion de la chaine d’approvisionnement, la réflexion longue peut assister à la prise de décisions complexes obligatoires pour répondre aux difficultés opérationnelles du moment et atteindre les objectifs stratégiques à long-terme. Les techniques de raisonnement peuvent aider les entreprises à minimiser les risques et à résoudre les problèmes d’évolutivité en anticipant et en évaluant plusieurs scénarios simultanément. De quoi améliorer la prévision de la demande, simplifier les trajets logistiques et opter pour des fournisseurs en phase avec les initiatives de développement durable de l’organisation.

Pour les entreprises qui opèrent à l’international, cette technique peut être employée pour créer des plans d’entreprise détaillés, pour générer du code complexe pour déboguer des logiciels ou pour optimiser les trajets des camions de livraison, des robots dans les entrepôts et des taxis autonomes.

Les modèles de raisonnement de l’IA évoluent rapidement. OpenAI o1-mini et o3-mini, DeepSeek R1, Google DeepMind’s Gemini 2.0 Flash Thinking : tous ont été annoncés au cours des dernières semaines, et d’autres modèles devraient bientôt faire leur apparition.

De tels modèles ont besoin de beaucoup plus de ressources de calcul pour raisonner pendant l’inférence et générer des réponses correctes à des questions complexes. Autrement dit, les entreprises doivent renforcer leurs ressources de calcul accéléré afin de rendre possible la nouvelle génération d’outils d’IA de raisonnement capables de résoudre des problèmes complexes, de proposer du code avancé et de planifier en plusieurs étapes.

Découvrez les avantages de NVIDIA AI pour accélérer l’inférence.